Seminar

this page reports on the seminar (or reading group) of the unit and offers associated documents (slides, video, references)

13 avril 2021: Sur les graphes de connaissances

Baptiste Abeloos

Introduction aux graphes de connaissances, à la notion de prédiction de liens, et présentation de l’article ConceptBert.

Introduction aux graphes de connaissances, à la notion de prédiction de liens, et présentation de l’article ConceptBert.

[PDF]

Références

- ConceptBert : https://www.aclweb.org/anthology/2020.findings-emnlp.44/

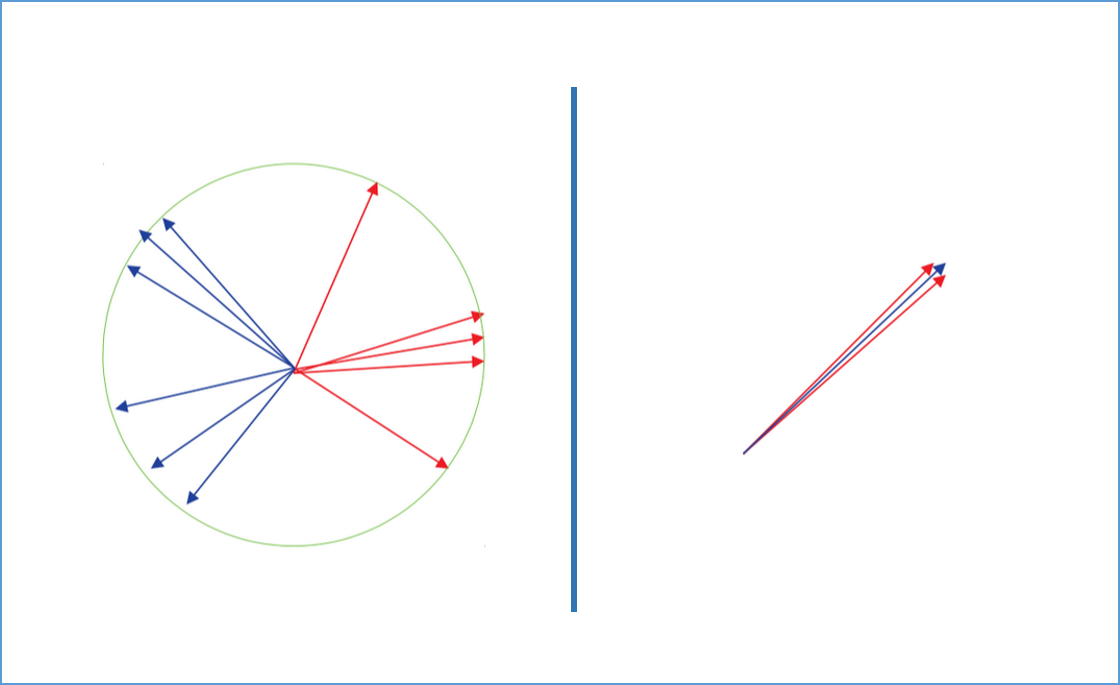

16 mars 2021: Sur la convergence des apprentissages

Adrien Chan Hon Tong

On présente qq articles et résultats sur le choix des paramètres d’optimisation d’un réseau (learning rate, batch size, etc.) et on s’interroge sur leur pertinence pour la segmentation sémantique.

On présente qq articles et résultats sur le choix des paramètres d’optimisation d’un réseau (learning rate, batch size, etc.) et on s’interroge sur leur pertinence pour la segmentation sémantique.

[PDF]

Références :

- 2006.15081 (deepmind) On the Generalization Benefit of Noise in Stochastic Gradient Descent

- 1907.04595 (Carnegie) Towards Explaining the Regularization Effect of Initial Large Learning Rate in Training Neural Networks

- 1907.04164 (deepmind) Which Algorithmic Choices Matter at Which Batch Sizes? Insights From a Noisy Quadratic Model

- 1704.04289 (Columbia) Stochastic Gradient Descent as Approximate Bayesian Inference

- Nips2019 (Chicago + Israël) Stochastic Gradient Descent on Separable Data: Exact Convergence with a Fixed Learning Rate

2 mars 2021: BERT

William Grison

Une présentation de BERT (Bidirectional Encoder Representations from Transformers) depuis son introduction en NLP jusqu’à ses applications en Vision.

Une présentation de BERT (Bidirectional Encoder Representations from Transformers) depuis son introduction en NLP jusqu’à ses applications en Vision.

[PDF] [Video]

Références :

- Devlin, J., Chang, M. W., Lee, K., & Toutanova, K. (2018). Bert: Pre-training of deep bidirectional transformers for language understanding. arXiv preprint arXiv:1810.04805.

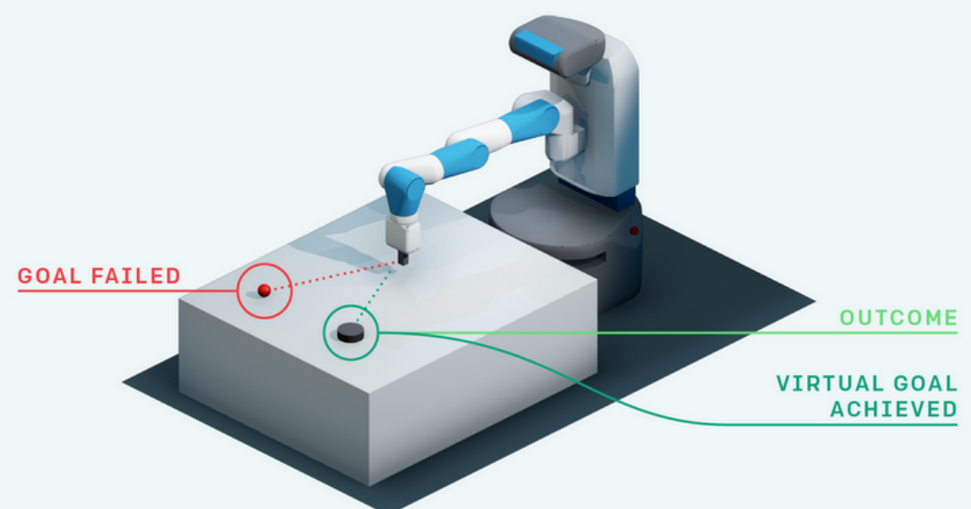

novembre 2020: RL: from basics to Hindsight Experience Replay

Pierre Fournier

Une introduction au deep reinforcement learning

Une introduction au deep reinforcement learning

[PDF]